خطرات هوش مصنوعی چیست؟ نحوه جلوگیری از آن

هوش مصنوعی (AI) در سالهای اخیر به یکی از مهمترین فناوریهای تحولآفرین تبدیل شده است. با پیشرفت سریع این فناوری، نگرانیها درباره خطر هوش مصنوعی نیز رو به افزایش است؛ از تهدیدهای شغلی و سوءاستفادههای سایبری گرفته تا تصمیمگیریهای ناعادلانه و تهدیدهای اخلاقی. ایمنی هوش مصنوعی امروزه به یکی از اصلیترین دغدغههای جهانی تبدیل شده و تلاشهای فراوانی برای جلوگیری از هوش مصنوعی آسیبرسان در حال انجام است. در این مطلب از هوشکس، به بررسی مهمترین ریسکها و راهکارهای مقابله با آنها میپردازیم.

هوش مصنوعی چیست؟

هوش مصنوعی (Artificial Intelligence) شاخهای از علوم کامپیوتر است که به طراحی و ساخت سیستمها و ماشینهایی میپردازد که توانایی انجام وظایفی را دارند که معمولا به هوش انسانی نیاز دارند. این وظایف شامل یادگیری، استدلال، تصمیمگیری، حل مسئله، درک زبان طبیعی و حتی تشخیص تصاویر و صداها میشود. هدف اصلی هوش مصنوعی، شبیهسازی تواناییهای ذهنی انسان در ماشینهاست؛ بهطوری که بتوانند بدون دخالت مستقیم انسان و با تکیه بر دادهها و الگوریتمها، بهطور خودکار عملکرد خود را بهبود دهند. امروزه AI در حوزههایی مانند پزشکی، حملونقل، اقتصاد، آموزش و امنیت مورد استفاده گسترده قرار گرفته و نقش پررنگی در شکلدهی آینده فناوری دارد.

برای اطلاعات بیشتر میتوانید مقاله: تفاوت هوش مصنوعی و هوش انسانی را مطالعه نمایید.

خطرات بالقوه هوش مصنوعی چیست؟

خطر هوش مصنوعی چیست؟ استفاده از هوش مصنوعی در کنار فواید فراوانی که دارد، خطراتی را هم به همراه دارد که در ادامه به آنها اشاره میکنیم:

- به خطر افتادن مشاغل انسانی: AI میتواند بخشی از مشاغل افراد را تحت تاثیر قرار دهد و حتی باعث از بین رفتن بعضی مشاغل شود.

- تصمیمگیریهای مغرضانه یا ناعادلانه: اگر دادههای آموزشی مغرضانه باشند، AI نیز تصمیماتی مغرضانه خواهد گرفت.

- نقض حریم خصوصی: جمعآوری و تحلیل دادههای شخصی توسط هوش مصنوعی میتواند به افشای اطلاعات حساس کاربران منجر شود.

- سوءاستفادههای نظامی و امنیتی: استفاده از AI در تولید سلاحهای خودکار یا ابزارهای جاسوسی تهدیدی برای صلح و امنیت جهانی است.

- افزایش حملات سایبری هوشمند: مهاجمان سایبری میتوانند با استفاده از AI حملاتی پیچیدهتر و مؤثرتر طراحی کنند.

- از دست رفتن کنترل بر سیستمها: سیستمهای خودآموز پیچیده ممکن است رفتارهایی خارج از کنترل یا پیشبینی انسان از خود نشان دهند.

- فریبکاری و جعل واقعیت (دیپ فیک): AI میتواند ویدیوها و صداهای جعلی اما بسیار واقعی تولید کند و باعث گسترش اطلاعات نادرست شود.

چگونه میتوان با این خطرات مقابله کرد؟

مقابله با خطر هوش مصنوعی نیازمند رویکردی ترکیبی از اقدامات فنی، سیاستگذاری هوشمند، آموزش عمومی و همکاری جهانی است. در ادامه، مهمترین راهکارهای عملی برای کاهش ریسک های هوش مصنوعی و افزایش ایمنی هوش مصنوعی آمده است:

طراحی اخلاقمحور و مسئولانه

یکی از مهمترین اقدامات برای جلوگیری از هوش مصنوعی آسیبزا، طراحی الگوریتمها بر پایه اصول اخلاقی است. توسعهدهندگان باید در فرایند طراحی، مسائلی مانند عدالت، بیطرفی، حفظ کرامت انسانی و پرهیز از تبعیض را در نظر بگیرند. الگوریتمهای AI باید طوری طراحی شوند که در تصمیمگیریها به اقشار آسیبپذیر لطمه نزنند و خروجی آنها برای همه قابل درک و قابل بررسی باشد. این نوع طراحی کمک میکند تا ایمنی هوش مصنوعی از ابتدا نهادینه شود و اعتماد عمومی به آن افزایش یابد.

ایجاد چارچوبهای قانونی و نظارتی

تدوین قوانین مشخص و نظارت مؤثر از سوی نهادهای حاکمیتی، گام مهمی در پیشگیری از خطر هوش مصنوعی است. بدون مقررات روشن، هیچ تضمینی برای استفاده درست، شفاف و مسئولانه از AI وجود ندارد. این چارچوبها باید شامل تعیین مسئولیتها، استانداردهای فنی، حقوق کاربران، و محدودیتهای استفاده از هوش مصنوعی در حوزههایی مانند نظارت یا جنگافزارها باشد. ایجاد نهادهای ناظر، امکان بررسی، ارزیابی و در صورت لزوم برخورد قانونی با تخلفات را فراهم میکند.

افزایش شفافیت الگوریتمها

هوش مصنوعی باید بهگونهای طراحی شود که تصمیماتش قابل پیگیری و توضیحپذیر باشند. این یعنی نهتنها متخصصان، بلکه کاربران عادی نیز بتوانند بفهمند که چرا یک سیستم AI تصمیم خاصی را اتخاذ کرده است. شفافسازی الگوریتمها به کاهش سوءتفاهمها، کشف خطاها و جلوگیری از بروز تبعیض کمک میکند. همچنین موجب میشود توسعهدهندگان مسئولیتپذیرتر عمل کنند و کاربران اعتماد بیشتری به سیستمها داشته باشند.

آموزش توسعهدهندگان و کاربران

بدون آگاهی، حتی پیشرفتهترین فناوریها میتوانند به خطر تبدیل شوند. توسعهدهندگان باید آموزش ببینند تا نهتنها با مهارتهای فنی، بلکه با مسائل حقوقی و اخلاقی مرتبط با هوش مصنوعی نیز آشنا باشند. از سوی دیگر، کاربران باید یاد بگیرند چگونه از AI بهدرستی استفاده کنند، چگونه دادههای شخصی خود را محافظت کنند، و در برابر نتایج گمراهکننده یا خطرناک هوشیار باشند. آموزش گسترده، سنگ بنای پیشگیری از آسیبهای AI در سطح فردی و اجتماعی است.

استفاده از سیستمهای بررسی و ارزیابی ریسک

پیش از راهاندازی هر سیستم مبتنی بر هوش مصنوعی، باید بررسیهای امنیتی، اخلاقی و عملکردی دقیقی روی آن انجام شود. ارزیابی ریسک میتواند نقاط ضعف سیستم را پیش از آنکه وارد محیط واقعی شود، شناسایی کند. این بررسیها باید با استفاده از چکلیستها و توسط تیمهای مستقل صورت گیرد تا از جانبداری جلوگیری شود. اجرای این مرحله بهصورت منظم، ضامن ایمنی هوش مصنوعی و محافظت از کاربران نهایی خواهد بود.

ذخیرهسازی ایمن دادهها و کنترل دسترسی

از آنجا که الگوریتمهای AI بر پایه دادهها آموزش میبینند، محافظت از این دادهها حیاتی است. اگر دادههای آموزشی یا اطلاعات کاربران به دست افراد یا نهادهای نادرست بیفتد، میتواند منجر به سوءاستفاده، تبعیض یا حملات سایبری شود. رمزگذاری دادهها، استفاده از سیستمهای مدیریت دسترسی، و ثبت گزارش فعالیتها از جمله روشهایی هستند که به ایمنسازی محیط کمک میکنند و مانع از تبدیل هوش مصنوعی به تهدید میشوند.

توسعه فناوریهای مقابله با سوءاستفاده

برای مقابله با تهدیدات احتمالی ناشی از هوش مصنوعی، باید فناوریهایی ایجاد شوند که خود بتوانند AIهای مخرب را شناسایی و متوقف کنند. ابزارهایی مانند سامانههای کشف دیپفیک، شناسایی الگوریتمهای مغرض، و هوش مصنوعی دفاعی در برابر حملات سایبری، نمونههایی از این فناوریها هستند. این اقدامات نهتنها برای جلوگیری از خطرات لازماند، بلکه میتوانند بخشی از معماری ایمنسازی هر پلتفرم هوشمند باشند.

همکاری بینالمللی

از آنجا که توسعه با هوش مصنوعی ابعاد جهانی دارد، تنها با همکاری میان کشورها میتوان از پیامدهای مخرب آن جلوگیری کرد. ایجاد توافقهای بینالمللی برای تعیین استانداردهای اخلاقی، فنی و امنیتی، مانع از سوءاستفاده دولتها یا شرکتها در سطح جهانی خواهد شد. همچنین، همکاری در تحقیقات و به اشتراکگذاری تجربیات موفق، مسیر بهکارگیری ایمن و سازنده هوش مصنوعی را هموارتر میکند.

این راهکارها اگر بهصورت هماهنگ اجرا شوند، میتوانند نقش بزرگی در محافظت از جوامع انسانی در برابر خطر هوش مصنوعی ایفا کنند و مسیر استفاده امن و هوشمندانه از این فناوری را هموار سازند.

در جهانی که خطر هوش مصنوعی واقعی است، تنها با آگاهی از ریسکها و تلاش برای جلوگیری میتوان آیندهای ایمن ساخت.

نقش شرکتها و توسعهدهندگان در پیشگیری از خطرات

شرکتها و توسعهدهندگان نقشی حیاتی در پیشگیری از خطرات هوش مصنوعی ایفا میکنند، چرا که آنها مستقیما در فرایند طراحی، توسعه و پیادهسازی این فناوری دخیلاند. مسئولیت این گروهها فراتر از نوآوری فنی است و شامل تعهد به اصول اخلاقی، شفافیت در عملکرد الگوریتمها و محافظت از دادههای کاربران میشود. توسعهدهندگان باید از دادههای بدون تعصب استفاده کرده و پیش از عرضه هر سیستم، آن را از نظر ایمنی، دقت و تأثیرات اجتماعی مورد ارزیابی قرار دهند. شرکتها نیز باید محیطی برای کنترل کیفیت، نظارت داخلی و پاسخگویی قانونی فراهم کنند. ایجاد مستندات دقیق، گزارشدهی منظم و همکاری با نهادهای نظارتی، از جمله اقداماتی است که میتواند در راستای ایمنی هوش مصنوعی و جلوگیری از هوش مصنوعی آسیبزا مؤثر باشد.

چگونه در برابر هوش مصنوعی از خود دفاع کنیم؟

برای دفاع از خود در برابر هوش مصنوعی، مهمترین گام افزایش آگاهی و سواد دیجیتال است. افراد باید درک درستی از نحوه کار الگوریتمها، جمعآوری و استفاده از دادهها و تأثیرات احتمالی هوش مصنوعی بر حریم خصوصی، امنیت و تصمیمگیریهای روزمره خود داشته باشند. استفاده از ابزارهایی برای محافظت از دادههای شخصی، مانند رمزنگاری، مدیریت دقیق تنظیمات حریم خصوصی در پلتفرمها و پرهیز از اشتراکگذاری بیملاحظه اطلاعات، از اقدامات ضروری است. همچنین، پیگیری اخبار و مقررات جدید در زمینه فناوری و مشارکت در گفتوگوهای عمومی درباره حقوق دیجیتال میتواند به افراد کمک کند تا در برابر تصمیمات ناعادلانه یا تبعیضآمیز ناشی از سیستمهای هوشمند، آگاهانه عمل کرده و در صورت لزوم اعتراض یا پیگیری قانونی کنند.

چگونه با این فناوری جدید همکاری کنیم؟

برای همکاری مؤثر با فناوری هوش مصنوعی، لازم است آن را نه بهعنوان تهدید، بلکه بهعنوان ابزاری توانمند برای بهبود کیفیت زندگی و کار در نظر بگیریم. این همکاری زمانی به نتیجه میرسد که انسانها نقش مکملی در کنار ماشینها ایفا کنند؛ یعنی از هوش مصنوعی برای افزایش بهرهوری، حل مسائل پیچیده و خودکارسازی وظایف تکراری بهره ببرند، در حالی که تصمیمگیریهای نهایی و ابعاد انسانی امور همچنان در اختیار انسان باقی بماند. برای این منظور، آموزش مهارتهای لازم برای استفاده و فهم فناوریهای هوش مصنوعی، ایجاد همکاری میان متخصصان فناوری و حوزههای انسانی، و طراحی سیستمهایی با رویکرد انسانمحور ضروری است. تنها در این صورت میتوان از ظرفیتهای این فناوری نوظهور بهشکلی سازنده و پایدار بهرهمند شد.

آیا هوش مصنوعی میتواند جایگزین انسان در فرایند طراحی شود؟

هوش مصنوعی میتواند در فرایند طراحی نقش مهمی ایفا کند، اما نمیتواند بهطور کامل جایگزین انسان شود. اگرچه الگوریتمهای هوش مصنوعی قادرند بر اساس دادههای موجود، طرحهایی خلق کنند یا پیشنهادهای خلاقانهای ارائه دهند، اما درک عمیق از زمینههای فرهنگی، عاطفی و انسانی طراحی همچنان نیازمند ذهن خلاق و شهودی انسان است. طراحی نهتنها مسئلهای فنی، بلکه فرآیندی است سرشار از احساس، الهام، و تجربه زیسته که هوش مصنوعی هنوز توانایی درک کامل آن را ندارد. بنابراین، آینده طراحی بیشتر بر تعامل و همکاری میان انسان و ماشین استوار خواهد بود تا جایگزینی کامل یکی بهجای دیگری.

چه مزایا و معایبی برای استفاده از آن وجود دارد؟

اگر میخواهید در یک نگاه مزایا و معایب استفاده از هوش مصنوعی را بدانید، ادامه مطلب را بخوانید:

مزایا:

- افزایش سرعت و دقت در انجام کارها

- کاهش هزینههای عملیاتی و نیروی انسانی

- توانایی پردازش و تحلیل حجم زیادی از دادهها

- امکان انجام وظایف تکراری و خستهکننده

معایب:

- از بین رفتن برخی مشاغل انسانی

- نبود شفافیت در تصمیمگیری الگوریتمها

- خطرات امنیتی و نشت دادههای حساس

- کاهش تعاملات انسانی و وابستگی به ماشینها

در آینده همکاری هوش مصنوعی به چه شکل خواهد بود؟

در آینده، همکاری با هوش مصنوعی به شکل تعاملات همافزا و مکمل میان انسان و ماشین خواهد بود. انسانها وظایف خلاقانه، راهبردی و تصمیمگیریهای احساسی را بر عهده خواهند داشت، در حالی که هوش مصنوعی پردازش دادهها، پیشبینی و اتوماسیون کارهای پیچیده و تکراری را انجام میدهد. این همکاری به ارتقاء بهرهوری، نوآوری و سرعت عمل در بسیاری از حوزهها منجر خواهد شد، مشروط بر اینکه بهدرستی مدیریت و هدایت شود.

برای اطلاعات بیشتر میتوانید مقاله: آینده ی هوش مصنوعی را مطالعه نمایید.

برای جلوگیری از حملات سایبری چه کاری انجام دهیم؟

برای جلوگیری از حملات سایبری، باید رویکردی چندلایه و پیشگیرانه در پیش گرفت. این شامل استفاده از نرمافزارهای امنیتی بهروز، رمزهای عبور قوی و چندمرحلهای، آموزش مستمر کاربران درباره تهدیدات سایبری و شناسایی حملات فیشینگ میشود. همچنین، بهروزرسانی منظم سیستمها و اپلیکیشنها، محدودسازی دسترسی به دادههای حساس، و استفاده از فایروالها و شبکههای ایمن از دیگر اقدامات کلیدی است. سازمانها نیز باید سیاستهای امنیتی شفافی داشته باشند و برنامههای پاسخگویی سریع به حملات را طراحی و اجرا کنند.

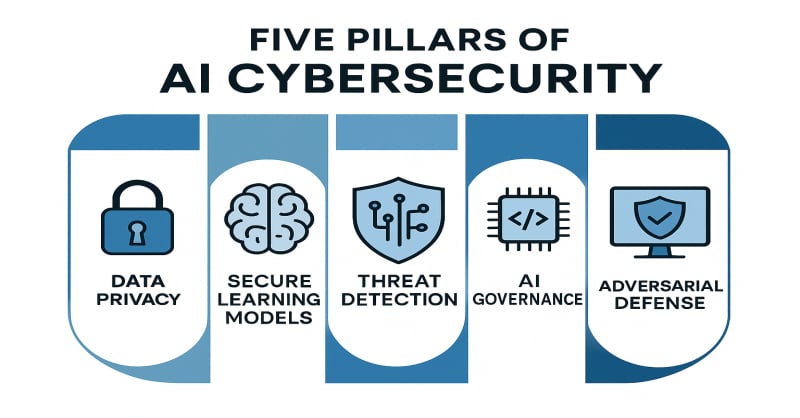

پنج پایه اصلی امنیت سایبری در هوش مصنوعی

پنج پایه اصلی امنیت سایبری در هوش مصنوعی عبارتند از:

- احراز هویت: اطمینان از اینکه فقط کاربران مجاز میتوانند به سیستمها و دادههای مبتنی بر هوش مصنوعی دسترسی پیدا کنند.

- تمامیت داده: حفاظت از دادهها در برابر تغییر، خراب شدن یا دستکاری، تا الگوریتمها فقط با دادههای درست و قابل اعتماد آموزش ببینند.

- محرمانگی: جلوگیری از دسترسی غیرمجاز به دادهها، بهویژه دادههای حساس کاربران که برای آموزش مدلهای هوش مصنوعی استفاده میشوند.

- قابلیت پاسخگویی: ثبت و مستندسازی تصمیمات، ورودیها و خروجیهای الگوریتمهای هوش مصنوعی برای پیگیری عملکرد و رفع اشکالات احتمالی.

- تابآوری : طراحی سیستمهایی که بتوانند در برابر حملات سایبری، خطاها یا اختلالات احتمالی مقاومت کنند و بهسرعت به شرایط امن بازگردند.

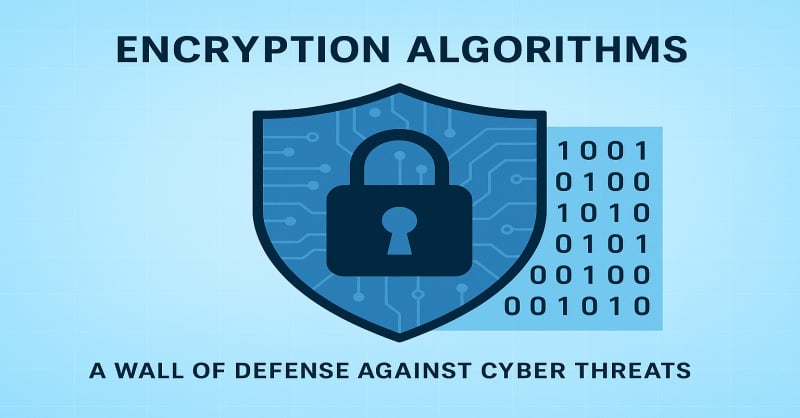

استفاده از الگوریتمهای رمزگذاری قوی

استفاده از الگوریتمهای رمزگذاری قوی یکی از مهمترین روشها برای حفاظت از دادهها در سیستمهای مبتنی بر هوش مصنوعی است. این الگوریتمها با تبدیل اطلاعات خام به دادههایی غیرقابل خواندن برای افراد غیرمجاز، مانع از دسترسی و سوءاستفاده احتمالی از اطلاعات حساس میشوند. در حوزه هوش مصنوعی، جایی که حجم زیادی از دادههای شخصی، مالی یا رفتاری برای آموزش مدلها بهکار میرود، رمزگذاری میتواند از نشت اطلاعات و حملات سایبری جلوگیری کند. همچنین استفاده از روشهای پیشرفتهای مانند رمزگذاری همگام با یادگیری ماشین (Homomorphic Encryption) امکان تحلیل دادهها را بدون نیاز به رمزگشایی فراهم میکند که گامی مهم در جهت امنیت و حریم خصوصی است.

طبق گزارش Cost of a Data Breach Report 2023 شرکت IBM، میانگین هزینه نقض داده برای سازمانهایی که از رمزگذاری قوی استفاده نکردهاند، ۴۵٪ بیشتر از سازمانهایی بوده که الگوریتمهای رمزنگاری پیشرفته دارند.

تأمین امنیت سایبری در هوش مصنوعی

تأمین امنیت سایبری در هوش مصنوعی به معنای محافظت از سیستمها، دادهها و مدلهای یادگیری ماشین در برابر تهدیدات دیجیتال است. از آنجایی که هوش مصنوعی برای تحلیل و تصمیمگیری به دادههای گسترده و گاه حساس وابسته است، هرگونه نفوذ یا دستکاری میتواند پیامدهای جبرانناپذیری داشته باشد. برای مقابله با خطر هوش مصنوعی، باید اقدامات پیشگیرانهای همچون بهروزرسانی مستمر سیستمها، استفاده از الگوریتمهای امن، نظارت مداوم بر عملکرد مدلها، و بررسی دقیق دادههای ورودی انجام شود. همچنین، طراحی مدلهای مقاوم در برابر حملات و آموزش تیمهای توسعهدهنده درباره امنیت دیجیتال از دیگر گامهای کلیدی در این زمینه است.

هوش مصنوعی ایمن، آیندهای پایدار

برای اینکه بتوانیم از فواید هوش مصنوعی بهره ببریم و از خطر هوش مصنوعی در امان بمانیم، باید از هماکنون روی ایمنی هوش مصنوعی تمرکز کنیم. آموزش عمومی، توسعه مسئولانه، همکاری بینالمللی و طراحی الگوریتمهای اخلاقمحور از گامهای حیاتی برای جلوگیری از هوش مصنوعی آسیبزا هستند. در نهایت، رویکردی آگاهانه و محتاطانه، مسیر همکاری امن میان انسان و ماشین را هموار خواهد کرد.

سپهر بیات

سپهر بیات، بنیانگذار «هوشِکس» و مدرسِ هوش مصنوعیِ کاربردی است. او با تمرکز بر نتیجه و اجرا، مفاهیم AI را به زبان ساده و عملی برای مدیران، فریلنسرها و دانشجویان تدریس میکند. دورهی پرچمدار او، «God-Mode» (خلق کسبوکار یکنفره با AI)، مسیر راهاندازی محصول و درآمد را گامبهگام نشان میدهد. سپهر در گفتوگو با چهرههای کلیدی صنعت و برگزاری رویدادهای تخصصی، بین دانش روز و نیازهای بازار پل میزند. اینجا دربارهی هوش مصنوعی مینویسد: دقیق، الهامبخش و کاملاً اجرامحور.

View All Posts by سپهر بیات